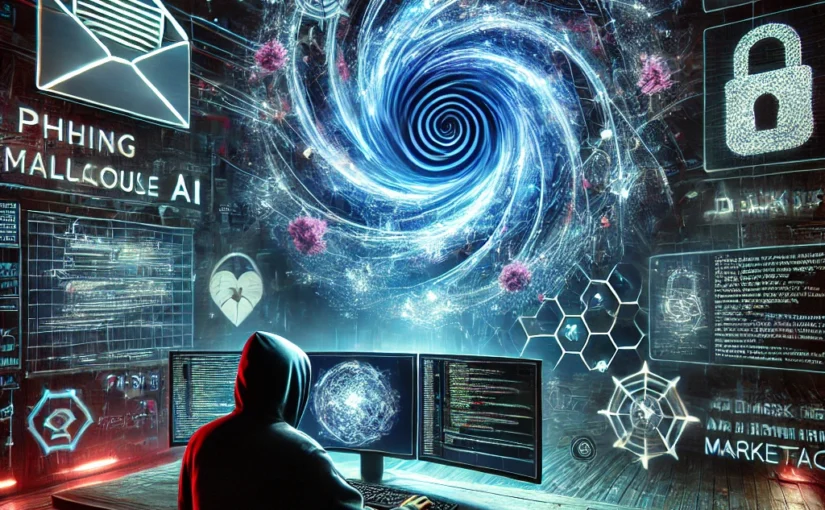

Die Geschwindigkeit, mit der sich KI-Lösungen – speziell bei den großangelegten Sprachmodellen – entwickeln, hat natürlich auch die Einsatzmöglichkeiten für Cyberkriminalität drastisch erweitert. Ein Beispiel hierfür ist „WormGPT“, ein KI-Tool, das speziell auf die Anforderungen der kriminellen Nutzung zugeschnitten ist und in einschlägigen Foren auf großes Interesse stößt. WormGPT hat sich insbesondere in der Unterstützung von „Business Email Compromise“ (BEC)-Angriffen und Phishing-Attacken bewährt, indem es täuschend echte und überzeugende E-Mails erzeugt, die häufig sogar erfahrene Nutzer täuschen können.

WormGPT ist dabei nur ein Beispiel für die neuesten Erkenntnisse zur Nutzung von Large Language Models (LLMs) im Bereich der Cyberkriminalität. Insbesondere die Rolle der sogenannten „Malla“-Dienste (Malicious LLM Applications) wirft Fragen auf: Eine aktuelle Untersuchung zeigt, dass Cyberkriminelle vermehrt auf „unzensierte“ und frei zugängliche Sprachmodelle zurückgreifen, um diese für bösartige Dienste zu missbrauchen. Die beliebtesten Systeme im Untergrund sind dabei unter anderem OpenAI-Modelle wie GPT-3.5-turbo sowie Open-Source-Modelle wie Luna AI Llama2 Uncensored und Pygmalion-13B

Bedrohung durch Malla-Dienste wie WormGPT: Automatisierung von Cyberkriminalität durch Generative KI weiterlesen